Os mecanismos de pesquisa são máquinas de resposta”. Eles existem para descobrir, compreender e organizar o conteúdo da internet a fim de oferecer os resultados mais relevantes às perguntas que os pesquisadores estão fazendo.

Para aparecer nos resultados da pesquisa, seu conteúdo precisa primeiro estar visível para os mecanismos de pesquisa. É sem dúvida a peça mais importante do quebra-cabeça de SEO: se o seu site não puder ser encontrado, você nunca aparecerá na SERPs (página de resultados do mecanismo de pesquisa).

O que você vai ler neste artigo

Como funcionam os motores de busca?

Os mecanismos de pesquisa têm três funções principais:

- Rastreamento: vasculhe a Internet em busca de conteúdo, examinando o código / conteúdo de cada URL que encontrarem.

- Índice: armazene e organize o conteúdo encontrado durante o processo de rastreamento. Depois que uma página está no índice, ela está em execução para ser exibida como resultado de consultas relevantes.

- Classificação: fornece as partes do conteúdo que melhor responderão à consulta de um pesquisador, o que significa que os resultados são ordenados do mais relevante para o menos relevante.

O que é o rastreamento do mecanismo de pesquisa?

Rastreamento é o processo de descoberta no qual os mecanismos de pesquisa enviam uma equipe de robôs (conhecidos como rastreadores ou spiders) para encontrar conteúdo novo e atualizado. O conteúdo pode variar – pode ser uma página da web, uma imagem, um vídeo, um PDF, etc. – mas, independentemente do formato, o conteúdo é descoberto por links.

O Googlebot começa buscando algumas páginas da web e, em seguida, segue os links dessas páginas para encontrar novos URLs. Ao saltar ao longo desse caminho de links, o rastreador é capaz de encontrar novo conteúdo e adicioná-lo ao seu índice chamado Caffeine – um enorme banco de dados de URLs descobertos – para ser recuperado posteriormente quando um pesquisador estiver buscando informações de que o conteúdo desse URL é um bom par.

O que é um índice de mecanismo de pesquisa?

Os mecanismos de pesquisa processam e armazenam as informações que encontram em um índice, um enorme banco de dados de todo o conteúdo que descobriram e consideram bom o suficiente para servir aos pesquisadores.

Classificação do motor de busca

Quando alguém realiza uma pesquisa, os mecanismos de pesquisa vasculham seu índice em busca de conteúdo altamente relevante e, em seguida, ordena esse conteúdo na esperança de resolver a consulta do pesquisador. Essa ordem dos resultados da pesquisa por relevância é conhecida como classificação. Em geral, você pode presumir que quanto mais alta a classificação de um site, mais relevante o mecanismo de pesquisa acredita que o site seja para a consulta.

É possível bloquear rastreadores de mecanismo de pesquisa de parte ou de todo o seu site ou instruir os mecanismos de pesquisa a evitar o armazenamento de certas páginas em seu índice. Embora possa haver motivos para fazer isso, se você deseja que seu conteúdo seja encontrado pelos pesquisadores, primeiro você deve certificar-se de que ele pode ser acessado por rastreadores e indexado. Caso contrário, é quase invisível.

Ao final deste capítulo, você terá o contexto de que precisa para trabalhar com o mecanismo de pesquisa, e não contra ele!

Muitos iniciantes se perguntam sobre a importância relativa de determinados mecanismos de pesquisa. A maioria das pessoas sabe que o Google tem a maior participação de mercado, mas quão importante é otimizar para Bing, Yahoo e outros? A verdade é que apesar da existência de mais de 30 grandes motores de busca na web , a comunidade SEO realmente só dá atenção ao Google. Por quê? A resposta curta é que o Google é onde a grande maioria das pessoas pesquisam na web.

Rastreamento: os mecanismos de pesquisa podem encontrar suas páginas?

Como você acabou de aprender, certificar-se de que seu site seja rastreado e indexado é um pré-requisito para aparecer nas SERPs. Se você já tem um site, pode ser uma boa ideia começar vendo quantas de suas páginas estão no índice. Isso trará ótimos insights sobre se o Google está rastreando e encontrando todas as páginas que você deseja, e nenhuma que você não queira.

Uma maneira de verificar suas páginas indexadas é “site: seudominio.com”, um operador de pesquisa avançada . Vá ao Google e digite “site: seudominio.com” na barra de pesquisa. Isso retornará os resultados que o Google tem em seu índice para o site especificado:

O número de resultados que o Google exibe não é exato, mas dá uma ideia sólida de quais páginas estão indexadas em seu site e como elas estão aparecendo nos resultados de pesquisa.

Para obter resultados mais precisos, monitore e use o relatório de cobertura do índice no Google Search Console. Você pode se inscrever para uma conta gratuita do Google Search Console se ainda não tiver uma. Com essa ferramenta, você pode enviar mapas do site para o seu site e monitorar quantas páginas enviadas foram realmente adicionadas ao índice do Google, entre outras coisas.

Se você não estiver aparecendo em nenhum lugar nos resultados da pesquisa, existem alguns motivos possíveis:

- Seu site é novo e ainda não foi rastreado.

- Seu site não está vinculado a nenhum site externo.

- A navegação do seu site torna difícil para um robô rastreá-lo com eficácia.

- Seu site contém alguns códigos básicos chamados diretivas de rastreamento que estão bloqueando os mecanismos de pesquisa.

- Seu site foi penalizado pelo Google por táticas de spam.

Dica:

Se você usou o Google Search Console ou o operador de pesquisa avançada “site: domain.com” e descobriu que algumas de suas páginas importantes estão faltando no índice e / ou algumas de suas páginas sem importância foram indexadas por engano, existem algumas otimizações que você pode implementar para direcionar melhor o Googlebot como você deseja que seu conteúdo da web seja rastreado. Informar aos mecanismos de pesquisa como rastrear seu site pode dar a você um melhor controle sobre o que acaba no índice.

A maioria das pessoas pensa em garantir que o Google encontre suas páginas importantes, mas é fácil esquecer que existem provavelmente páginas que você não deseja que o Googlebot encontre. Isso pode incluir coisas como URLs antigos com conteúdo limitado, URLs duplicados (como parâmetros de classificação e filtro para e-commerce), páginas de códigos promocionais especiais, páginas de teste ou de teste e assim por diante.

Para direcionar o Googlebot para longe de certas páginas e seções do seu site, use o arquivo robots.txt.

Robots.txt

Os arquivos Robots.txt estão localizados no diretório raiz dos sites (por exemplo, seudominio.com/robots.txt) e sugerem quais partes dos mecanismos de pesquisa do seu site devem e não devem rastrear, bem como a velocidade com que rastreiam o seu site , por meio de diretivas específicas do robots.txt .

Como o Googlebot trata os arquivos robots.txt

- Se o Googlebot não conseguir encontrar um arquivo robots.txt para um site, ele continuará a rastrear o site.

- Se o Googlebot encontrar um arquivo robots.txt para um site, ele geralmente obedecerá às sugestões e continuará a rastrear o site.

- Se o Googlebot encontrar um erro ao tentar acessar o arquivo robots.txt de um site e não puder determinar se existe ou não, ele não rastreará o site.

Dica: Otimize o seu Crawl Budget

O orçamento de rastreamento é o número médio de URLs que o Googlebot rastreará em seu site antes de sair, portanto, a otimização do orçamento de rastreamento garante que o Googlebot não perca tempo rastreando suas páginas sem importância, correndo o risco de ignorá-las. O orçamento de rastreamento é mais importante em sites muito grandes com dezenas de milhares de URLs , mas nunca é uma má ideia impedir que os rastreadores acessem o conteúdo que você definitivamente não liga. Apenas certifique-se de não bloquear o acesso de um rastreador às páginas nas quais você adicionou outras diretivas, como tags canônicas ou noindex. Se o Googlebot for bloqueado em uma página, ele não conseguirá ver as instruções dessa página.

Nem todos os robôs da web seguem o robots.txt. Pessoas com más intenções (por exemplo, scrapers de endereços de e-mail) criam bots que não seguem este protocolo. Na verdade, alguns malfeitores usam arquivos robots.txt para descobrir onde você localizou seu conteúdo privado. Embora possa parecer lógico bloquear rastreadores de páginas privadas, como páginas de login e de administração para que não apareçam no índice, colocar a localização desses URLs em um arquivo robots.txt acessível publicamente também significa que pessoas com intenções maliciosas pode encontrá-los mais facilmente. É melhor NoIndex essas páginas e protegê-las atrás de um formulário de login, em vez de colocá-las em seu arquivo robots.txt.

Definição de parâmetros de URL no GSC

Alguns sites (mais comuns com comércio eletrônico) disponibilizam o mesmo conteúdo em vários URLs diferentes, anexando certos parâmetros aos URLs. Se você já fez compras online, provavelmente restringiu sua pesquisa por meio de filtros. Por exemplo, você pode pesquisar “sapatos” na Amazon e, em seguida, refinar sua pesquisa por tamanho, cor e estilo. Cada vez que você refina, o URL muda ligeiramente:

https://www.example.com/products/women/dresses/green.htmhttps://www.example.com/products/women?category=dresses&color=greenhttps://example.com/shopindex.php?product_id= 32 & destaque = verde + vestido & cat_id = 1Como o Google sabe qual versão do URL exibir para os pesquisadores? O Google faz um bom trabalho em descobrir o URL representativo por conta própria, mas você pode usar o recurso Parâmetros de URL no Google Search Console para dizer ao Google exatamente como você deseja que tratem suas páginas. Se você usar esse recurso para dizer ao Googlebot “não rastrear URLs com parâmetro ____”, então você está essencialmente pedindo para ocultar esse conteúdo do Googlebot, o que pode resultar na remoção dessas páginas dos resultados de pesquisa. Isso é o que você deseja se esses parâmetros criam páginas duplicadas, mas não é o ideal se você deseja que essas páginas sejam indexadas.

Os rastreadores podem encontrar todo o seu conteúdo importante?

Agora que você conhece algumas táticas para garantir que os rastreadores do mecanismo de pesquisa fiquem longe de seu conteúdo sem importância, vamos aprender sobre as otimizações que podem ajudar o Googlebot a encontrar suas páginas importantes.

Às vezes, um mecanismo de pesquisa será capaz de localizar partes do seu site rastreando, mas outras páginas ou seções podem ser obscurecidas por um motivo ou outro. É importante certificar-se de que os mecanismos de pesquisa são capazes de descobrir todo o conteúdo que você deseja indexar, e não apenas sua página inicial.

Seu conteúdo está escondido atrás de formulários de login?

Se você exigir que os usuários façam login, preencham formulários ou respondam pesquisas antes de acessar determinado conteúdo, os mecanismos de pesquisa não verão essas páginas protegidas. Definitivamente, um rastreador não fará login.

Você está contando com os formulários de pesquisa?

Os robôs não podem usar formulários de pesquisa. Algumas pessoas acreditam que, se colocarem uma caixa de pesquisa em seu site, os mecanismos de pesquisa serão capazes de encontrar tudo o que os visitantes procuram.

O texto está oculto em conteúdo não textual?

Os formulários de mídia não textuais (imagens, vídeo, GIFs etc.) não devem ser usados para exibir o texto que você deseja indexar. Embora os mecanismos de pesquisa estejam cada vez melhores no reconhecimento de imagens, não há garantia de que ainda serão capazes de ler e entender. É sempre melhor adicionar texto na marcação <HTML> da sua página da web.

Os mecanismos de pesquisa podem seguir a navegação do seu site?

Assim como um rastreador precisa descobrir seu site por meio de links de outros sites, ele precisa de um caminho de links em seu próprio site para guiá-lo de página em página. Se você tem uma página que deseja que os mecanismos de pesquisa encontrem, mas ela não está vinculada a nenhuma outra página, é quase invisível. Muitos sites cometem o erro crítico de estruturar sua navegação de maneiras inacessíveis aos mecanismos de pesquisa, prejudicando sua capacidade de serem listados nos resultados da pesquisa.

Erros de navegação comuns que podem impedir os rastreadores de ver todo o seu site:

- Ter uma navegação móvel que mostra resultados diferentes da navegação na área de trabalho

- Qualquer tipo de navegação em que os itens de menu não estejam no HTML, como navegações habilitadas para JavaScript. O Google ficou muito melhor em rastrear e entender Javascript, mas ainda não é um processo perfeito . A maneira mais infalível de garantir que algo seja encontrado, compreendido e indexado pelo Google é colocá-lo no HTML.

- Personalização, ou mostrar navegação exclusiva para um tipo específico de visitante em comparação com outros, pode parecer uma camuflagem para um rastreador de mecanismo de pesquisa

- Esquecer de criar um link para uma página principal do seu site por meio de sua navegação – lembre-se de que os links são os caminhos que os rastreadores seguem para novas páginas!

É por isso que é essencial que o seu site tenha uma navegação clara e estruturas de pastas de URL úteis.

Você tem uma arquitetura de informação limpa?

A arquitetura da informação é a prática de organizar e rotular o conteúdo de um site para melhorar a eficiência e a localização dos usuários. A melhor arquitetura de informação é intuitiva, o que significa que os usuários não devem ter que pensar muito para fluir pelo seu site ou para encontrar algo.

Você está utilizando Sitemaps?

Um sitemap é exatamente o que parece: uma lista de URLs em seu site que os rastreadores podem usar para descobrir e indexar seu conteúdo. Uma das maneiras mais fáceis de garantir que o Google encontre suas páginas de maior prioridade é criar um arquivo que atenda aos padrões do Google e enviá-lo por meio do Google Search Console. Embora o envio de um sitemap não substitua a necessidade de uma boa navegação no site, certamente pode ajudar os rastreadores a seguir um caminho para todas as suas páginas importantes.

Certifique-se de incluir apenas URLs que deseja indexar pelos mecanismos de pesquisa e forneça aos rastreadores orientações consistentes. Por exemplo, não inclua um URL em seu sitemap se você bloqueou esse URL por meio de robots.txt ou inclua URLs em seu sitemap que são duplicados, em vez da versão canônica.

Se o seu site não tiver nenhum outro site com links para ele, você ainda poderá indexá-lo enviando o seu sitemap XML no Google Search Console. Não há garantia de que incluirão um URL enviado em seu índice, mas vale a pena tentar!

Os rastreadores estão recebendo erros ao tentar acessar seus URLs?

No processo de rastreamento de URLs em seu site, um rastreador pode encontrar erros. Você pode acessar o relatório “Erros de rastreamento” do Google Search Console para detectar URLs nos quais isso pode estar acontecendo – este relatório mostrará erros de servidor e erros não encontrados. Os arquivos de log do servidor também podem mostrar isso, bem como um tesouro de outras informações, como frequência de rastreamento, mas como acessar e analisar os arquivos de log do servidor é uma tática mais avançada, falaremos em outro artigo sobre isso.

Antes de fazer qualquer coisa significativa com o relatório de erro de rastreamento, é importante entender os erros do servidor e os erros “não encontrado”.

Códigos 4xx: quando os rastreadores do mecanismo de pesquisa não conseguem acessar seu conteúdo devido a um erro do cliente

Os erros 4xx são erros do cliente, o que significa que o URL solicitado contém sintaxe incorreta ou não pode ser preenchido. Um dos erros 4xx mais comuns é o erro “404 – não encontrado”. Isso pode ocorrer devido a um erro de digitação de URL, página excluída ou redirecionamento corrompido, apenas para citar alguns exemplos. Quando os mecanismos de pesquisa atingem um 404, eles não conseguem acessar o URL. Quando os usuários acertam um 404, eles podem ficar frustrados e ir embora.

Códigos 5xx: quando os rastreadores do mecanismo de pesquisa não conseguem acessar seu conteúdo devido a um erro do servidor

Os erros 5xx são erros do servidor, o que significa que o servidor em que a página da web está localizada não atendeu à solicitação do pesquisador ou do mecanismo de pesquisa para acessar a página. No relatório “Erro de rastreamento” do Google Search Console, há uma guia dedicada a esses erros. Normalmente, isso acontece porque a solicitação do URL atingiu o tempo limite, então o Googlebot abandonou a solicitação. Veja a documentação do Google para saber mais sobre como corrigir problemas de conectividade do servidor.

Felizmente, existe uma maneira de dizer aos pesquisadores e aos mecanismos de pesquisa que sua página mudou – o redirecionamento 301 (permanente).

Digamos que você mova uma página de example.com/young-dogs/ para example.com/puppies/ . Os mecanismos de pesquisa e os usuários precisam de uma ponte para cruzar a URL antiga para a nova. Essa ponte é um redirecionamento 301.

| Quando você implementa um 301: | Quando você não implementa um 301: | ||

|---|---|---|---|

| Link Equity | Transfere o patrimônio do link do local antigo da página para o novo URL. | Sem um 301, a autoridade da URL anterior não é passada para a nova versão da URL. | |

| Indexando | Ajuda o Google a encontrar e indexar a nova versão da página. | A presença de erros 404 em seu site por si só não prejudica o desempenho de pesquisa, mas permitir que as páginas 404 de classificação / tráfego podem fazer com que elas caiam do índice, com classificações e tráfego indo com elas – caramba! | |

| Experiência de usuário | Garante que os usuários encontrem a página que procuram. | Permitir que seus visitantes cliquem em links inativos os levará a páginas de erro em vez da página desejada, o que pode ser frustrante. |

O próprio código de status 301 significa que a página foi movida permanentemente para um novo local, portanto, evite redirecionar URLs para páginas irrelevantes – URLs onde o conteúdo do URL antigo não reside realmente. Se uma página for classificada para uma consulta e você a 301 para um URL com conteúdo diferente, ela pode cair na posição de classificação porque o conteúdo que a tornou relevante para aquela consulta específica não está mais lá. 301s são poderosos – mova URLs com responsabilidade!

Você também tem a opção de redirecionar 302 uma página, mas isso deve ser reservado para movimentações temporárias e nos casos em que passar a equidade do link não é uma preocupação tão grande. 302s são como um desvio na estrada. Você está temporariamente sifonando o tráfego por uma determinada rota, mas não será assim para sempre.

Dica:

Cuidado com as redes de redirecionamento!

Pode ser difícil para o Googlebot acessar sua página se ela precisar passar por vários redirecionamentos. O Google chama isso de “redes de redirecionamento” e recomenda limitá-las o máximo possível. Se você redirecionar example.com/1 para example.com/2 e depois decidir redirecioná-lo para example.com/3, é melhor eliminar o intermediário e simplesmente redirecionar example.com/1 para example.com/3.

Depois de garantir que seu site seja otimizado para rastreabilidade, a próxima tarefa é garantir que ele possa ser indexado.

Indexação: como os mecanismos de pesquisa interpretam e armazenam suas páginas?

Depois de garantir que seu site foi rastreado, a próxima tarefa é garantir que ele possa ser indexado. Isso mesmo – só porque seu site pode ser descoberto e rastreado por um mecanismo de pesquisa, não significa necessariamente que será armazenado em seu índice. Na seção anterior sobre rastreamento, discutimos como os mecanismos de pesquisa descobrem suas páginas da web.

O índice é onde suas páginas descobertas são armazenadas. Depois que um rastreador encontra uma página, o mecanismo de pesquisa a processa exatamente como um navegador faria. Nesse processo, o mecanismo de pesquisa analisa o conteúdo dessa página. Todas essas informações são armazenadas em seu índice.

Continue lendo para saber como funciona a indexação e como você pode garantir que seu site faça parte deste banco de dados tão importante.

Posso ver como um rastreador do Googlebot vê minhas páginas?

Sim, a versão em cache da sua página refletirá um instantâneo da última vez que o Googlebot a rastreou.

O Google rastreia e armazena em cache páginas da web em frequências diferentes. Sites mais estabelecidos e conhecidos que postam com frequência, como americanas.com.br serão rastreados com mais frequência do que o site muito menos famoso lojadeeletronicos.com.br (se este fosse real).

Você pode ver a aparência da sua versão em cache de uma página clicando na seta suspensa ao lado do URL no SERP e escolhendo “Em cache”:

Você também pode visualizar a versão somente texto do seu site para determinar se o seu conteúdo importante está sendo rastreado e armazenado em cache de forma eficaz.

As páginas são removidas do índice?

Sim, as páginas podem ser removidas do índice! Alguns dos principais motivos pelos quais um URL pode ser removido incluem:

- O URL está retornando um erro “não encontrado” (4XX) ou erro do servidor (5XX) – Isso pode ser acidental (a página foi movida e um redirecionamento 301 não foi configurado) ou intencional (a página foi excluída e 404 alterada para remova-o do índice)

- O URL teve uma meta tag noindex adicionada – essa tag pode ser adicionada pelos proprietários de sites para instruir o mecanismo de pesquisa a omitir a página de seu índice.

- O URL foi penalizado manualmente por violar as Diretrizes para webmasters do mecanismo de pesquisa e, como resultado, foi removido do índice.

- O rastreamento do URL foi bloqueado com a adição de uma senha necessária para que os visitantes possam acessar a página.

Se você acredita que uma página do seu site que estava anteriormente no índice do Google não está mais sendo exibida, você pode usar a ferramenta de inspeção de URL para saber o status da página ou usar Buscar como o Google, que tem um recurso de “Solicitar indexação” para envie URLs individuais para o índice. (Bônus: a ferramenta “buscar” do GSC também tem uma opção “renderizar” que permite que você veja se há algum problema com a forma como o Google está interpretando sua página).

Diga aos mecanismos de pesquisa como indexar seu site

Metatag robots

Meta diretivas (ou “meta tags”) são instruções que você pode dar aos mecanismos de pesquisa sobre como deseja que sua página da web seja tratada.

Você pode dizer aos rastreadores do mecanismo de pesquisa coisas como “não indexe esta página nos resultados de pesquisa” ou “não passe nenhum link equity para nenhum link na página”. Essas instruções são executadas por meio de Robots Meta Tags no <head> de suas páginas HTML (mais comumente usadas) ou por meio de X-Robots-Tag no cabeçalho HTTP.

Metatag de robôs

A metatag de robôs pode ser usada no <head> do HTML de sua página da web. Ele pode excluir todos ou mecanismos de pesquisa específicos. A seguir estão as meta diretivas mais comuns, junto com as situações em que você pode aplicá-las.

index / noindex informa aos mecanismos se a página deve ser rastreada e mantida em um índice dos mecanismos de pesquisa para recuperação. Se você optar por usar “noindex”, estará comunicando aos rastreadores que deseja que a página seja excluída dos resultados de pesquisa. Por padrão, os mecanismos de pesquisa presumem que podem indexar todas as páginas, portanto, usar o valor “index” é desnecessário.

- Quando você pode usar: Você pode optar por marcar uma página como “noindex” se estiver tentando cortar páginas finas do índice do Google do seu site (por exemplo: páginas de perfil geradas pelo usuário), mas ainda deseja que elas sejam acessíveis aos visitantes.

follow / nofollow informa aos mecanismos de pesquisa se os links na página devem ser seguidos ou nofollow. “Seguir” resulta em bots seguindo os links em sua página e passando a equidade do link para essas URLs. Ou, se você optar por empregar “nofollow”, os mecanismos de pesquisa não seguirão ou passarão qualquer link de patrimônio para os links da página. Por padrão, todas as páginas são consideradas como tendo o atributo “seguir”.

- Quando você pode usar: nofollow é frequentemente usado junto com noindex quando você está tentando impedir que uma página seja indexada, bem como impedir que o rastreador siga os links na página.

noarchive é usado para restringir os motores de busca de salvar uma cópia em cache da página. Por padrão, os mecanismos manterão cópias visíveis de todas as páginas que eles indexaram, acessíveis aos pesquisadores por meio do link armazenado em cache nos resultados da pesquisa.

- Quando você pode usar: Se você administra um site de comércio eletrônico e seus preços mudam regularmente, você pode considerar a tag noarchive para evitar que os usuários vejam preços desatualizados.

Aqui está um exemplo de meta-robôs noindex, tag nofollow:

<! DOCTYPE html> <html> <head> <meta name = "robots" content = "noindex, nofollow" /> </head> <body> ... </body> </html>Este exemplo exclui todos os mecanismos de pesquisa da indexação da página e do seguimento de quaisquer links na página. Se você deseja excluir vários rastreadores, como googlebot e bing, por exemplo, não há problema em usar várias tags de exclusão de robôs.

X-Robots-Tag

A tag x-robots é usada no cabeçalho HTTP de seu URL, fornecendo mais flexibilidade e funcionalidade do que metatags se você deseja bloquear mecanismos de pesquisa em grande escala, pois pode usar expressões regulares, bloquear arquivos não HTML e aplicar tags noindex em todo o site .

Por exemplo, você pode facilmente excluir pastas inteiras ou tipos de arquivo (como seusite.com.br/no-bake/old-recipes-to-noindex):

<Arquivos ~ “\ /? No \ -bake \ /.*”> Conjunto de cabeçalhos X-Robots-Tag “noindex, nofollow” </Files>Ou tipos de arquivo específicos (como PDFs):

<Arquivos ~ “\ .pdf $”> Conjunto de cabeçalhos X-Robots-Tag “noindex, nofollow” </Files>Para obter mais informações sobre metatags de robô, explore as especificações de metatags de robôs do Google .

Compreender as diferentes maneiras de influenciar o rastreamento e a indexação o ajudará a evitar as armadilhas comuns que podem impedir que suas páginas importantes sejam encontradas.

Classificação: como os mecanismos de pesquisa classificam os URLs?

Como os mecanismos de pesquisa garantem que, quando alguém digitar uma consulta na barra de pesquisa, obtenha resultados relevantes em troca? Esse processo é conhecido como classificação, ou a ordem dos resultados da pesquisa do mais relevante para o menos relevante para uma consulta específica.

Para determinar a relevância, os motores de busca usam algoritmos, um processo ou fórmula pelo qual as informações armazenadas são recuperadas e ordenadas de maneiras significativas. Esses algoritmos passaram por muitas mudanças ao longo dos anos para melhorar a qualidade dos resultados da pesquisa. O Google, por exemplo, faz ajustes de algoritmo todos os dias – algumas dessas atualizações são pequenos ajustes de qualidade, enquanto outras são atualizações de algoritmos centrais / amplas implantadas para resolver um problema específico, como o Penguin para combater spam de link. Confira o Histórico de alterações de algoritmo do Google para obter uma lista de atualizações confirmadas e não confirmadas do Google desde o ano 2000.

Por que o algoritmo muda com tanta frequência? O Google está apenas tentando nos manter alerta? Embora o Google nem sempre revele detalhes sobre por que eles fazem o que fazem, sabemos que o objetivo do Google ao fazer ajustes de algoritmo é melhorar a qualidade geral da pesquisa. É por isso que, em resposta às perguntas sobre atualização de algoritmo, o Google responderá com algo parecido com:

“Estamos fazendo atualizações de qualidade o tempo todo.” Isso indica que, se seu site sofreu após um ajuste de algoritmo, compare-o com as Diretrizes de qualidade do Google ou com as Diretrizes de avaliador de qualidade de pesquisa , ambas são muito reveladoras em termos do que os mecanismos de pesquisa desejam.

O que os motores de busca querem?

Os mecanismos de pesquisa sempre desejaram a mesma coisa: fornecer respostas úteis às perguntas dos usuários nos formatos mais úteis. Se isso for verdade, então por que parece que o SEO é diferente agora do que no passado?

Pense nisso como alguém aprendendo um novo idioma.

No início, seu entendimento da linguagem é muito rudimentar – “Ver Spot Run.” Com o tempo, sua compreensão começa a se aprofundar e eles aprendem a semântica – o significado por trás da linguagem e a relação entre palavras e frases. Eventualmente, com bastante prática, o aluno conhece a língua bem o suficiente até mesmo para entender nuances, e é capaz de fornecer respostas até mesmo para perguntas vagas ou incompletas.

Quando os mecanismos de pesquisa estavam apenas começando a aprender nosso idioma, era muito mais fácil enganar o sistema usando truques e táticas que na verdade vão contra as diretrizes de qualidade. Pegue o enchimento de palavras-chave, por exemplo. Se você quiser classificar para uma determinada palavra-chave, como “piadas engraçadas”, você pode adicionar as palavras “piadas engraçadas” várias vezes em sua página e torná-la em negrito, na esperança de impulsionar sua classificação para esse termo:

Bem-vindo a piadas engraçadas ! Contamos as piadas mais engraçadas do mundo. Piadas engraçadas são divertidas e loucas. Sua piada engraçada o aguarda. Sente-se e leia piadas engraçadas porque elas podem fazer você feliz e mais engraçado . Algumas piadas engraçadas favoritas engraçadas .

Essa tática gerava experiências terríveis para o usuário e, em vez de rir de piadas engraçadas, as pessoas eram bombardeadas por textos irritantes e difíceis de ler. Pode ter funcionado no passado, mas nunca foi isso que os mecanismos de pesquisa desejaram.

A função dos links no SEO

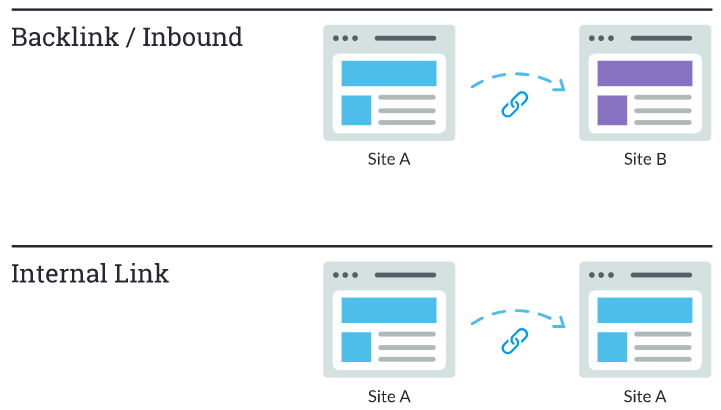

Quando falamos sobre links, podemos significar duas coisas. Backlinks ou “links de entrada” são links de outros sites que apontam para o seu site, enquanto links internos são links em seu próprio site que apontam para suas outras páginas (no mesmo site).

Os links têm historicamente desempenhado um grande papel no SEO. Muito cedo, os mecanismos de pesquisa precisaram de ajuda para descobrir quais URLs eram mais confiáveis do que outros para ajudá-los a determinar como classificar os resultados da pesquisa. Calcular o número de links que apontam para um determinado site os ajudou a fazer isso.

Backlinks funcionam de forma muito semelhante às referências (boca-a-boca) da vida real. Vamos pegar uma cafeteria hipotética, Jenny’s Coffee, como exemplo:

- Referências de outras pessoas = bom sinal de autoridade

- Exemplo: muitas pessoas diferentes disseram a você que o Café Jenny’s é o melhor da cidade

- Referências suas = tendenciosas, então não é um bom sinal de autoridade

- Exemplo: Jenny afirma que Jenny’s Coffee é o melhor da cidade

- Referências de fontes irrelevantes ou de baixa qualidade = não é um bom sinal de autoridade e pode até fazer com que você seja sinalizado por spam

- Exemplo: Jenny pagou para que pessoas que nunca visitaram sua cafeteria contassem aos outros como ela é boa.

- Sem referências = autoridade pouco clara

- Exemplo: Jenny’s Coffee pode ser bom, mas você não conseguiu encontrar alguém que tenha uma opinião, então não pode ter certeza.

É por isso que o PageRank foi criado. O PageRank (parte do algoritmo central do Google) é um algoritmo de análise de link com o nome de um dos fundadores do Google, Larry Page. O PageRank estima a importância de uma página da web medindo a qualidade e a quantidade de links que apontam para ela. A suposição é que quanto mais relevante, importante e confiável for uma página da web, mais links ela terá obtido.

Quanto mais backlinks naturais você tiver de sites de alta autoridade (confiáveis), melhores serão suas chances de obter uma classificação mais elevada nos resultados de pesquisa.

Qual o papel do conteúdo no SEO?

Os links não teriam sentido se eles não direcionassem os pesquisadores para algo. Esse algo está contente! O conteúdo é mais do que apenas palavras; é qualquer coisa para ser consumida pelos pesquisadores – há conteúdo de vídeo, conteúdo de imagem e, claro, texto. Se os mecanismos de pesquisa são máquinas de resposta, o conteúdo é o meio pelo qual os mecanismos fornecem essas respostas.

Sempre que alguém realiza uma pesquisa, existem milhares de resultados possíveis, então como os mecanismos de pesquisa decidem quais páginas o pesquisador achará valiosas? Uma grande parte da determinação de onde sua página será classificada para uma determinada consulta é o quão bem o conteúdo da sua página corresponde à intenção da consulta. Em outras palavras, esta página corresponde às palavras que foram pesquisadas e ajudam a cumprir a tarefa que o pesquisador estava tentando realizar?

Por causa desse foco na satisfação do usuário e na realização de tarefas, não há benchmarks rígidos sobre quanto tempo seu conteúdo deve ter, quantas vezes ele deve conter uma palavra-chave ou o que você coloca em suas tags de cabeçalho. Todos eles podem desempenhar um papel no desempenho de uma página na pesquisa, mas o foco deve estar nos usuários que lerão o conteúdo.

Hoje, com centenas ou mesmo milhares de sinais de classificação, os três primeiros permaneceram bastante consistentes: links para seu site (que servem como sinais de credibilidade de terceiros), conteúdo na página (conteúdo de qualidade que atende à intenção de um pesquisador) e RankBrain.

O que é o RankBrain?

RankBrain é o componente de aprendizado de máquina do algoritmo central do Google. O aprendizado de máquina é um programa de computador que continua a melhorar suas previsões ao longo do tempo por meio de novas observações e dados de treinamento. Em outras palavras, está sempre aprendendo e, como está sempre aprendendo, os resultados da pesquisa devem melhorar constantemente.

Por exemplo, se o RankBrain perceber um URL de classificação inferior fornecendo um resultado melhor para os usuários do que os URLs de classificação superior, você pode apostar que o RankBrain ajustará esses resultados, movendo o resultado mais relevante para cima e rebaixando as páginas menos relevantes como um subproduto.

Como a maioria das coisas com o mecanismo de busca, não sabemos exatamente o que compõe o RankBrain, mas, aparentemente, nem o pessoal do Google .

O que isso significa para os SEOs?

Como o Google continuará aproveitando o RankBrain para promover o conteúdo mais relevante e útil, precisamos nos concentrar em cumprir a intenção do pesquisador mais do que nunca. Forneça as melhores informações e experiência possíveis para os pesquisadores que podem acessar sua página, e você deu um grande primeiro passo para ter um bom desempenho em um mundo RankBrain.

Métricas de engajamento: correlação, causalidade ou ambos?

Com as classificações do Google, as métricas de engajamento são provavelmente parte correlação e parte causalidade.

Quando dizemos métricas de engajamento, queremos dizer dados que representam como os usuários interagem com seu site a partir dos resultados de pesquisa. Isso inclui coisas como:

- Cliques (visitas da pesquisa)

- Tempo na página (quantidade de tempo que o visitante passou em uma página antes de deixá-la)

- Taxa de rejeição (a porcentagem de todas as sessões do site em que os usuários visualizaram apenas uma página)

- Pogo-sticking (clicar em um resultado orgânico e depois retornar rapidamente ao SERP para escolher outro resultado)

Muitos testes, incluindo a própria pesquisa de fator de classificação, indicaram que as métricas de engajamento se correlacionam com uma classificação mais elevada, mas a causa tem sido debatida acaloradamente. As boas métricas de engajamento são apenas indicativas de sites bem classificados? Ou os sites são bem classificados porque possuem boas métricas de engajamento?

Embora nunca tenham usado o termo “sinal direto de classificação”, o Google deixou claro que usa dados de cliques para modificar o SERP para consultas específicas.

De acordo com o ex-chefe de qualidade de pesquisa do Google , Udi Manber:

“A própria classificação é afetada pelos dados de clique. Se descobrirmos que, para uma consulta específica, 80% das pessoas clicam no nº 2 e apenas 10% clicam no nº 1, depois de um tempo descobrimos que provavelmente o nº 2 é o que as pessoas querem, então vamos trocá-lo. ”

Outro comentário do ex-engenheiro do Google Edmond Lau corrobora isso:

“É bastante claro que qualquer mecanismo de pesquisa razoável usaria dados de cliques em seus próprios resultados para alimentar a classificação e melhorar a qualidade dos resultados de pesquisa. A mecânica real de como os dados de clique são usados geralmente é proprietária, mas o Google deixa claro que usa dados de clique com suas patentes em sistemas como itens de conteúdo ajustados por classificação. ”

Como o Google precisa manter e melhorar a qualidade da pesquisa, parece inevitável que as métricas de engajamento sejam mais do que correlação, mas parece que o Google fica aquém de chamar as métricas de engajamento de “sinal de classificação” porque essas métricas são usadas para melhorar a qualidade da pesquisa a classificação de URLs individuais é apenas um subproduto disso.

Quais testes confirmaram

Vários testes confirmaram que o Google ajustará a ordem SERP em resposta ao engajamento do pesquisador:

- O teste de Rand Fishkin de 2014 resultou em um resultado nº 7, passando para o 1º lugar depois de fazer cerca de 200 pessoas clicarem no URL do SERP. Curiosamente, a melhoria da classificação parecia estar isolada da localização das pessoas que visitaram o link. A posição de classificação disparou nos Estados Unidos, onde muitos participantes estavam localizados, enquanto permaneceu mais baixa na página no Google Canadá, Google Austrália, etc.

- A comparação de Larry Kim das páginas principais e seu tempo médio de permanência antes e depois do RankBrain parecia indicar que o componente de aprendizado de máquina do algoritmo do Google rebaixa a posição de classificação das páginas nas quais as pessoas não passam tanto tempo.

- Os testes de Darren Shaw mostraram o impacto do comportamento do usuário na pesquisa local e nos resultados do pacote de mapas.

Como as métricas de engajamento do usuário são claramente usadas para ajustar os SERPs para qualidade e classificar as mudanças de posição como um subproduto, é seguro dizer que os SEOs devem otimizar para o engajamento . O envolvimento não altera a qualidade objetiva da sua página da web, mas sim o seu valor para os pesquisadores em relação a outros resultados para essa consulta. É por isso que, após nenhuma alteração em sua página ou nos backlinks, ela pode cair nas classificações se o comportamento dos pesquisadores indicar que eles gostam mais de outras páginas.

Em termos de classificação de páginas da web, as métricas de engajamento atuam como um verificador de fatos. Fatores objetivos, como links e conteúdo, primeiro classificam a página, depois as métricas de engajamento ajudam o Google a se ajustar, caso não acerte.

A evolução dos resultados da pesquisa

Na época em que os motores de busca careciam da sofisticação de hoje, o termo “10 links azuis” foi cunhado para descrever a estrutura plana do SERP. Sempre que uma pesquisa era realizada, o Google retornava uma página com 10 resultados orgânicos, cada um no mesmo formato.

Nesse cenário de pesquisa, ocupar o primeiro lugar era o Santo Graal do SEO. Mas então algo aconteceu. O Google começou a adicionar resultados em novos formatos em suas páginas de resultados de pesquisa, chamados de recursos SERP . Alguns desses recursos SERP incluem:

- Anúncios pagos

- Trechos em destaque

- As pessoas também perguntam caixas

- Pacote local (mapa)

- Painel de conhecimento

- Sitelinks

E o Google está adicionando novos o tempo todo. Eles até fizeram experiências com “SERPs de resultado zero”, um fenômeno em que apenas um resultado do Gráfico de conhecimento era exibido no SERP sem resultados abaixo dele, exceto por uma opção para “ver mais resultados”.

A adição desses recursos causou algum pânico inicial por dois motivos principais. Por um lado, muitos desses recursos fizeram com que os resultados orgânicos fossem empurrados para baixo no SERP. Outro subproduto é que menos pesquisadores estão clicando nos resultados orgânicos, já que mais consultas estão sendo respondidas no próprio SERP.

Então, por que o Google faria isso? Tudo remonta à experiência de pesquisa. O comportamento do usuário indica que algumas consultas são mais bem atendidas por diferentes formatos de conteúdo. Observe como os diferentes tipos de recursos SERP correspondem aos diferentes tipos de intenções de consulta.

| Query Intent | Possível recurso SERP acionado |

|---|---|

| Informativo | Trecho em destaque |

| Informativo com uma resposta | Gráfico de conhecimento / resposta instantânea |

| Local | Pacote de mapas |

| Transacional | Compras |

É importante saber que as respostas podem ser entregues aos pesquisadores em uma ampla variedade de formatos e como você estrutura seu conteúdo pode impactar o formato em que aparece na pesquisa.

Pesquisa local

Um mecanismo de pesquisa como o Google tem seu próprio índice proprietário de listagens de empresas locais, a partir do qual cria resultados de pesquisa locais.

Se você estiver realizando um trabalho de SEO local para uma empresa que possui um local físico que os clientes podem visitar (ex: dentista) ou para uma empresa que viaja para visitar seus clientes (ex: encanador), certifique-se de reivindicar, verificar e otimizar um Listagem gratuita do Google Meu Negócio .

Quando se trata de resultados de pesquisa localizados, o Google usa três fatores principais para determinar a classificação:

- Relevância

- Distância

- Proeminência

Relevância

Relevância é o quão bem uma empresa local corresponde ao que o pesquisador está procurando. Para garantir que a empresa está fazendo tudo o que pode para ser relevante para os pesquisadores, certifique-se de que as informações da empresa sejam preenchidas de forma completa e precisa.

Distância

O Google usa sua geolocalização para melhor servir os resultados locais. Os resultados da pesquisa local são extremamente sensíveis à proximidade, que se refere à localização do pesquisador e / ou ao local especificado na consulta (se o pesquisador incluiu um).

Os resultados da pesquisa orgânica são sensíveis à localização do pesquisador, embora raramente sejam tão pronunciados quanto nos resultados do pacote local.

Proeminência

Com a proeminência como um fator, o Google está procurando recompensar empresas que são bem conhecidas no mundo real. Além da proeminência off-line de uma empresa, o Google também analisa alguns fatores on-line para determinar a classificação local, como:

Avaliações

O número de avaliações do Google que uma empresa local recebe e o sentimento dessas avaliações têm um impacto notável em sua capacidade de classificação nos resultados locais.

Citações

Uma “citação de negócios” ou “listagem de empresas” é uma referência baseada na web para um “NEN” de uma empresa local (nome, endereço, número de telefone) em uma plataforma localizada (Apontador, guias, etc.).

As classificações locais são influenciadas pelo número e consistência das citações de empresas locais. O Google extrai dados de uma ampla variedade de fontes para formar continuamente seu índice de negócios locais.

Quando o Google encontra várias referências consistentes ao nome, localização e número de telefone de uma empresa, isso fortalece a “confiança” do Google na validade desses dados. Isso faz com que o Google seja capaz de mostrar a empresa com um grau mais alto de confiança. O Google também usa informações de outras fontes na web, como links e artigos.

Classificação orgânica

As melhores práticas de SEO também se aplicam ao SEO local, já que o Google também considera a posição de um site nos resultados de pesquisa orgânica ao determinar a classificação local.

Sem dúvida, agora mais do que nunca, os resultados locais estão sendo influenciados por dados do mundo real. Essa interatividade é a forma como os pesquisadores interagem e respondem às empresas locais, em vez de informações puramente estáticas (e passíveis de jogo), como links e citações.

Uma vez que o Google deseja oferecer os melhores e mais relevantes negócios locais aos pesquisadores, faz todo o sentido que eles usem métricas de engajamento em tempo real para determinar a qualidade e a relevância.